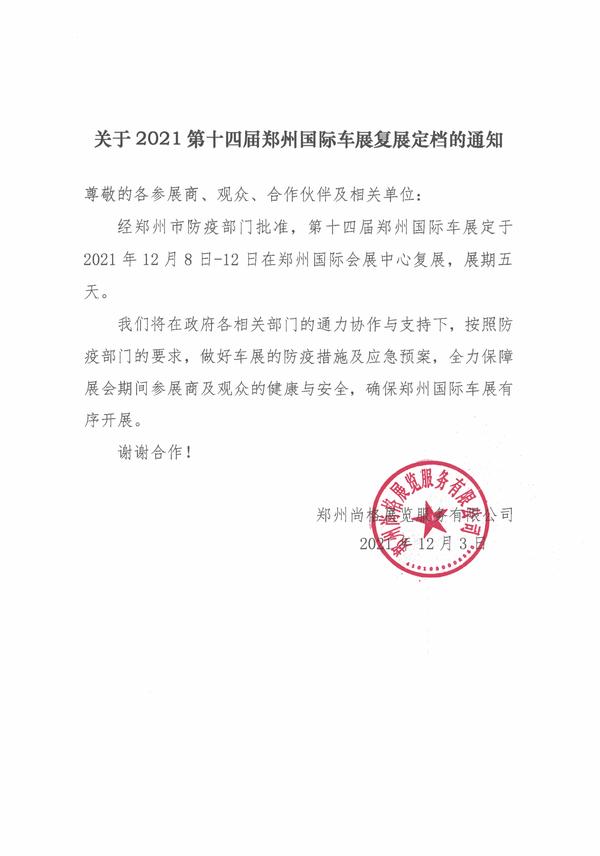

36 氪获悉,6 月 7 日,虎博科技正式发布并开源其自研大模型 TigerBot。同时,虎博科技还发布了大模型应用开发所需的全套 API,以及多领域专业数据。

虎博科技成立于 2017 年,是一家专注于深度学习及 NLP(自然语言处理)技术的 AI 公司,36 氪曾多次报道。此前,经过多年技术探索和积累,虎博科技已经拥有包括智能搜索、智能推荐、机器阅读理解、总结、翻译、舆情分析及撰稿在内的关键技术,亦有全球各行业的专业信息数据积累。

(相关资料图)

(相关资料图)

2022 年 11 月,OpenAI 发布 ChatGPT,掀起了全球的 AI 大模型科技浪潮,中国市场也出现了不少团队自研 AI 大模型的尝试,虎博科技也是其中之一。

本次虎博科技所发布的自研大模型 TigerBot,是一个多语言多任务大规模语言模型,经历 3 个月的封闭式开发和超过 3000 次实验迭代,当前已经迭代出第一个 MVP 版本。

从功能上,Tigerbot 已经包含大部分生成和理解类的能力,具体包括几大部分:

内容生成:辅助用户解决创作类问题,快速生成营销文案、评论、新闻稿等等。另外,Tigetbot 也支持图片生成——模型可以实现文生图,进行插图创作等

图片生成

开放问答:用户向 Tigerbot 提出问题,比如烹饪攻略、长文本总结、文本理解、角色对话、润色等等

开放式问答

提取信息:比如有目的地获取关键信息、提取数字、主要内容等等

长文本解读

在 3 个月封闭开发背后,是一支精干的团队。虎博科技创始人兼 CEO 陈烨对 36 氪表示,在大模型研发上,虎博团队致敬了硅谷经典的 " 车库创业 " 模式,团队开始只有 5 个人,CEO 同时担任首席程序员及首席 AI 科学家。

" 在大模型的研发上,我们坚信顶尖团队能起到的作用,团队规模不必太大,但技术需要过硬。在我们从 0 到 1 的研发过程中,我们核心的研发团队一直保持在 4-5 个人,以及密切合作的研发状态。" 陈烨表示。

从模型效果上看,虎博 Tigerbot 根据 OpenAI InstructGPT 论文的公开 NLP 数据集上进行评测,TigerBot-7B 对应 OpenAI 同等规模的 6B 版本,其综合表现能够达到 OpenAI 效果的 96%。

以 OpenAI-instruct GPT-6B-SFT 为基准,归一化并平均各模型的得分情况 来源:虎博科技

在过去三个月中,虎博科技主要基于 GPT 和 BLOOM 两个开源模型基础上,在模型架构和算法侧做了一系列优化。陈烨对 36 氪表示,虎博科技在技术突破上,主要集中在原创的监督和微调方法上。" 从整个技术角度来说,监督微调的方法是大模型这件事的核心,能够影响模型效果的七到八成。"

比如,大模型浪潮来临后,困扰业界的一个难题在于大模型的 " 幻觉 " ——即大模型输出的结果,和人类说的话一样自然,但在事实层面会 " 胡说八道 "。

陈烨以实际案例举例,针对这一问题,虎博应用了一些经典的监督学习方法,如 Ensemble 和 Probabilistic Modeling,结合到大模型中。

" 假设人类在问模型一个事实性问题,Tigerbot 不会只是简单地生成自然语言,而是同步利用更少量的数据就能知道人类意图——在回答上,则会更好的权衡事实性和创造性。" 陈烨补充。这样的结果是,机器在训练模型中算力和数据的消耗,会比同等档次模型要小。

针对中文语境,虎博科技从分词器(Tokenizer)到训练算法等方面做了针对性算法优化,使得模型更懂中文指令,提高了问答结果的中国文化属性。(注:这里调后了一段,因为在模型里,事实性和创造性决定了它是不是会胡说八道,中文环境的针对性算法优化,可以让它更懂中国人的交流,类似于几个同学在一起,总有 1 个比其他人文学底蕴更好一点)

而在并训练上,虎博的大模型团队也突破了比如 deep-speed 等主流框架中若内存和通信问题,使得在千卡环境下,可实现训练数间断。

虎博科技在大模型研发上选择走开源路线。此次开源内容包含模型、代码、数据三部分,包含 TigerBot-7B-sft、 TigerBot-7B-base、TigerBot-180B-research 等多个模型版本;基本训练且覆盖双卡推理 180B 模型的量化和推理代码;以及达 100G 的预训练数据、监督微调 1G/100 万条数据。

目前,这些内容已经全部在 Github 中发布(链接见此)。之所以选择开源路线,陈烨表示,推进人类文明的技术变革往往源于本能、直觉和偶然性,拥有自由的创新精神是根本。

" 大模型技术就像是一门新兴学科,是颠覆式且长周期的,未来的可能性超越 PC 和互联网。现阶段过早和过于理性地探讨产品、应用、场景和商业化或许没有必要,更重要的是推广这一人工智能基础设施的原创突破,促进技术的发展和更新。"

出于上述的考虑,虎博除了一部分积累的预训练数据集,也同时开源了系统性的中文数据搜集和清洗方法论。陈烨并不认为数据会成为壁垒:" 更重要的是团队对于数据清洗的理论和系统性的高度,这是一个长期的系统工程。"

虎博科技自成立之初就专注在中文 NLP 的技术和产品研发上,积累了大量高质量的中文预训练数据,本次发布的 100G 预训练数据,就是其中的一部分。未来,虎博还将开放大量的金融、法律、百科等领域专业数据,供应用开发者使用。

此前几年,虎博科技基于 NLP,开发了主要面向泛金融领域的 NLP 产品,如舆情监测、搜索、知识图谱等,也已经用 api 的方式服务 B 端客户。本次大模型的发布也会与虎博的业务相结合——当前,虎博科技已经面向老客户提供包括内容生成类的功能模块。陈烨表示,大模型技术浪潮来临后,在市场侧感觉 " 客户决策速度比以前更快,产品落地速度也更快。"

未来,虎博科技将持续投入力量到大模型的研发和落地中。陈烨谈及了正在研发或者正在完善的一些功能,如研究助手 TigerDoc、文创和营销工具等,虎博科技也正在内测部分面向个人的类助手产品。

欢迎交流

欢迎关注

-

全球时讯:5月末我国外汇储备规模为31765亿美元

头条 23-06-07

-

年内四次增持!重庆水投成重庆银行第五大股东

头条 23-06-07

-

中石油北京项目管理公司:胡某勇被免去相关职务 并接受纪委核查 世界观天下

头条 23-06-07

-

2022年信托行业评级初评结果出炉

头条 23-06-07

-

天天快资讯:郑州海昌海洋公园一期预计年内开业,14.36亿银团贷款落地

头条 23-06-07

-

当前速讯:辣椒种植、乡村建设有了5G“大脑”,河南乡村振兴跑出“加速度”

头条 23-06-07

-

多家大行6月8日起下调人民币存款利率_全球快播报

头条 23-06-07

-

要闻:郑东新区牵手豫信电科,围绕先进计算、数字政府建设等领域合作

头条 23-06-07

-

新资讯:零容忍!微信进一步打击不良直播PK行为

头条 23-06-07

-

河南种业集团更名完成!注册资本5亿元,侯传伟任董事长

头条 23-06-07

-

宁德时代重挫带崩锂电板快,机构:新能源赛道已不再拥挤

头条 23-06-07

-

揭秘!高考试卷从命题到进考场全流程→_当前热讯

头条 23-06-07

-

环球时讯:亿利洁能资金悬疑:手握43亿现金却致7亿票据逾期?

头条 23-06-07

-

@河南高考考生,忘带准考证在这些平台可下单免费跑腿→

头条 23-06-07

-

浙江第四批集采确认纳入重组人生长激素_全球热讯

头条 23-06-07

-

新乡投资集团将发行10亿元中票,申购区间3.20%~4.50% 环球速看

头条 23-06-07

-

全球时讯:加码自救!千亿地产紧急出招

头条 23-06-07

-

速递!河南农担公司:省财政贴息担保贷款 助力乡村产业振兴

头条 23-06-07

-

上海推出今年第五批次集中供应楼盘,备案均价最高为8.91万元/平方米

头条 23-06-07

-

焦作市经济运行工作会议:全力以赴抓招商,推动签约项目尽早落地

头条 23-06-07

-

今日报丨长安汽车被曝扣供应商货款!最新回应称“内容不实,已报案”

头条 23-06-07

-

涉卡转账、立即停止!中消协:警惕培训班退费骗局_环球短讯

头条 23-06-07

-

孟晚舟:万物正走向可感知、互联、智能 数字孪生世界正在构建_全球速讯

头条 23-06-07

-

长安汽车回应网传克扣10%货款:不实 已报案 环球快消息

头条 23-06-07

-

众泰汽车收关注函,被要求说明*ST庞大是否向公司输送利益

头条 23-06-07

-

当前聚焦:刚刚,华为重大发布!孟晚舟发声

头条 23-06-07

-

濮阳投资集团将发行5亿元中票,申购区间为4.8%~6%_每日报道

头条 23-06-07

-

陕西省公示47家重点产业链链主企业 | 名单

头条 23-06-07

-

天天热点!郑州启动经开综合保税区产业转型升级,公开招标规划编制

头条 23-06-07

-

李云泽会见美国花旗集团首席执行官范洁恩_天天快讯

头条 23-06-07

-

环球热推荐:河南省自然资源投资集团完成发行3.8亿元中票,利率3.88%

头条 23-06-07

-

比亚迪:将于2023年推出极具专业性、个性化的全新品牌_热点聚焦

头条 23-06-07

-

全球最资讯丨中国台球协会:将从严处罚旅英涉赌球员 开展全行业警示教育

头条 23-06-07

-

河南一批金融机构高管任职资格获核准 | 名单 全球今日讯

头条 23-06-07

-

多家大行存款利率将再迎下调,机构称板块估值进入配置区间 焦点快播

头条 23-06-07

-

寿险产品定价利率下调在即 年金险、分红险有望接力|天天简讯

头条 23-06-07

-

兰考县投资集团、产投集团揭牌

头条 23-06-07

-

长安汽车回应被供应商申诉其强行扣10%货款:未收到申诉 目前内部正在核查 天天热点评

头条 23-06-07

-

环球微头条丨湖南石化注册成立,由长岭炼化、巴陵石化整合组建

头条 23-06-07

-

【全球速看料】浙江拟推荐31家全国商贸物流重点联系企业 | 名单

头条 23-06-07

-

商丘将加强县域商业体系建设:支持县城商贸流通企业下沉业务_天天日报

头条 23-06-07

-

16省份公布去年平均工资:多地采矿业收入最高

头条 23-06-07

-

正式分家!周鸿祎与前妻离婚股份过户完成,最新市值68亿元

头条 23-06-07

-

河南省二手车出口试点企业评审结果公示,28家企业在列 每日时讯

头条 23-06-07

-

隔夜欧美·6月7日-每日简讯

头条 23-06-07

-

世界聚焦:河南省首次开展审计整改情况再审计再监督

头条 23-06-07

-

1~5月河南省重点城市房企销售业绩排行榜 天天速看料

头条 23-06-07

-

"中国取消大规模进口订单",什么情况?日股彻底疯狂:暴涨64000亿 快看

头条 23-06-07

-

皮海洲:分拆上市尽可能避免在同一市场内部进行-全球观察

头条 23-06-07

-

新动态:多地购房政策优化力度加大,专家:预计房地产行业6月份或迎新的政策出台

头条 23-06-07

-

红杉资本宣布拆分,全球三大区域将不再共用同一品牌 每日时讯

头条 23-06-07

-

新动态:世界银行上调中国2023年经济增速预期至5.6%

头条 23-06-07

-

洛阳中超股份创业板IPO申请获受理,拟募资12.4亿元

头条 23-06-06

-

热文:证监会核发7个企业债注册批文 总募资约180亿元

头条 23-06-06

-

【环球报资讯】河南组织专家开展科技服务,支持兰考、睢县、宁陵、汝阳发展

头条 23-06-06

- 当前信息:「虎博科技」发布自研多模态大模2023-06-07

- 开“运”随手拍丨和“水”打了一辈子交道,2023-06-07

- 疑似海盗母船!中国海军出手相助2023-06-07

- 环球观速讯丨河南各地加强服务保障 确保收2023-06-07

- 浙江:昔日“烂泥稻田”村 蹚出文旅振兴路2023-06-07

- 国企领导与年轻女子亲密逛街,公司通报:免2023-06-07

- 每日速递:应急管理部:5月我国各种自然灾2023-06-07

- 拒收房产而收开发商47万现金,住建局长被举2023-06-07

- 山东德州一科目三考场晒麦,多名学员挂科,2023-06-07

- 观察:49岁年轻奶奶抱孙子给19岁的小儿子送2023-06-07

- 全球时讯:5月末我国外汇储备规模为31765亿2023-06-07

- 年内四次增持!重庆水投成重庆银行第五大股2023-06-07

- 中石油北京项目管理公司:胡某勇被免去相关2023-06-07

- 2022年信托行业评级初评结果出炉2023-06-07

- 天天快资讯:郑州海昌海洋公园一期预计年内2023-06-07

- 私密抗衰守护者 | 全国女性生殖整形研修2023-06-07

- 今日纸黄金价格走势最新查询(2023年6月7日2023-06-07

- 多空相互影响 金价延续震荡2023-06-07

- 学子奔赴考场!新高考分为“3+3”和“3+1+22023-06-07

- 环球微资讯!四川:因地制宜书写“土地文章2023-06-07

- 启程的少年们,愿你们大胜归来!2023-06-07

- 高考次日天气如何?这些考场要继续留意高温2023-06-07

- 当前速看:高考第一天 全国各地爱心助考 2023-06-07

- 倒计时20天!天津夏季达沃斯论坛6月27日开幕2023-06-07

- 浙江:昔日“烂泥稻田”村 蹚出文旅振兴路2023-06-07

- 天天报道:一箭26星发射成功!我国一箭多星2023-06-07

- 看热讯:中国石油北京项目管理公司通报:胡2023-06-07

- 环球即时:应急管理部:今年5月各种自然灾2023-06-07

- 最新:港媒:泰国组合粉丝见面会主持人发涉2023-06-07

- 孙亮受贿、贪污、国有公司人员滥用职权案一2023-06-07